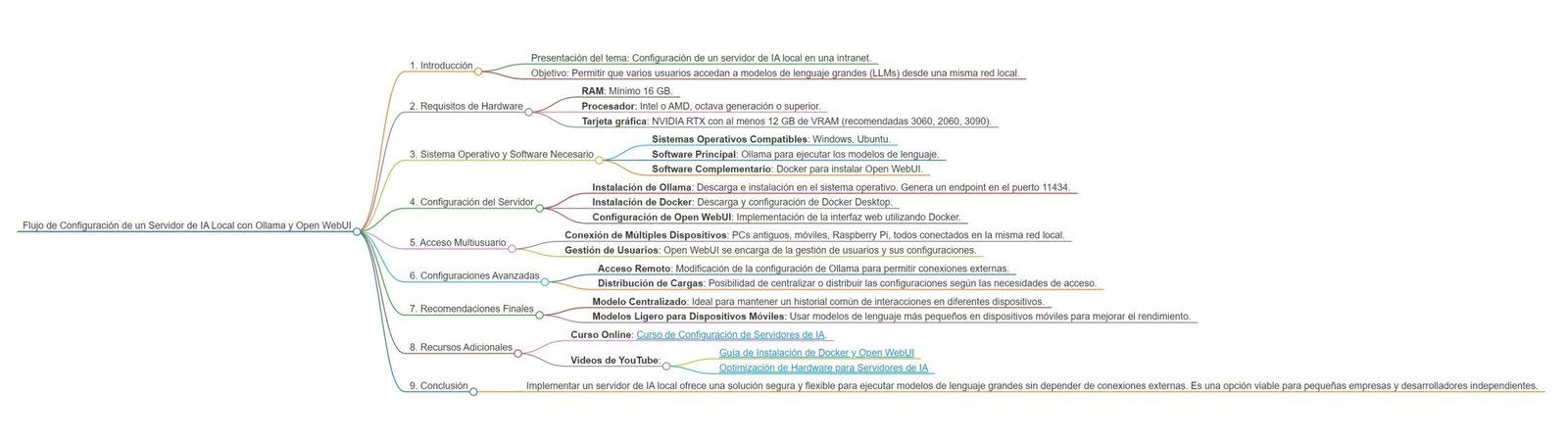

Introducción

En la era de la inteligencia artificial, la capacidad de tener un servidor de IA local multiusuario se ha convertido en una necesidad crucial para varios sectores. Configurar un servidor de IA local no solo le brinda control total sobre los datos y las operaciones, sino que también garantiza que el acceso y la disponibilidad de los recursos de IA se puedan gestionar eficientemente. Esto es especialmente importante en entornos donde la privacidad y la seguridad de los datos son prioritarias.

El propósito de este artículo es proporcionar una guía completa sobre cómo configurar un servidor de IA local multiusuario utilizando dos herramientas principales: Ollama y Open WebUI. Estas herramientas han demostrado ser eficaces y fáciles de usar, facilitando así la implementación y el mantenimiento de un sistema de IA robusto dentro de su propio entorno.

Las ventajas de utilizar Ollama y Open WebUI son numerosas. Ollama ofrece un marco flexible que permite el desarrollo y la gestión de modelos de IA en un entorno colaborativo. Por otro lado, Open WebUI proporciona una interfaz de usuario intuitiva que permite a los usuarios interactuar con los modelos de IA de manera sencilla. Juntas, estas herramientas ofrecen una solución integrada que es ideal tanto para principiantes como para expertos en el campo de la inteligencia artificial.

A lo largo de este artículo, exploraremos varios escenarios de uso comunes para un servidor de IA local multiusuario. En entornos educativos, estas configuraciones permiten a los estudiantes y profesores experimentar con modelos de IA en tiempo real, fomentando un aprendizaje más profundo y aplicado. En proyectos de investigación, facilitan la colaboración entre diferentes investigadores, permitiendo compartir recursos y resultados de manera eficiente. Finalmente, en aplicaciones comerciales, un servidor de IA local multiusuario puede mejorar el servicio al cliente, optimizar operaciones y generar análisis de datos más precisos y específicos.

Requisitos del Hardware

Para configurar un servidor de IA local multiusuario eficiente utilizando Ollama y Open WebUI, es fundamental contar con el hardware adecuado. Los requisitos mínimos y recomendados aseguran que el sistema funcione de manera óptima, soportando múltiples usuarios y aplicaciones de inteligencia artificial de forma simultánea.

Como punto de partida, es esencial disponer de al menos 16 GB de RAM. La memoria RAM juega un papel crucial en el manejo de grandes volúmenes de datos y en la ejecución de procesos complejos propios de las aplicaciones de IA. A mayor capacidad, mejor será el rendimiento, minimizando tiempos de espera y evitando sobrecargas del sistema.

El procesador es otro componente clave. Se recomienda el uso de un procesador Intel o AMD de octava generación o superior. Estos procesadores ofrecen un balance adecuado entre velocidad y eficiencia, permitiendo procesar algoritmos de IA de manera ágil y eficiente. Modelos como el Intel i7 o el Ryzen 7 son ideales, dada su capacidad para manejar múltiples hilos de ejecución simultáneamente.

La tarjeta gráfica (GPU) también es esencial. Para un rendimiento óptimo, es preferible una tarjeta gráfica Nvidia RTX con al menos 12 GB de VRAM. Las GPUs son fundamentales en el procesamiento paralelo, acelerando considerablemente las tareas de IA. Modelos recomendados incluyen la Nvidia RTX 3060 o la 2060. Estas tarjetas gráficas no solo proporcionan la potencia necesaria para ejecutar modelos complejos, sino que también garantizan una mayor eficiencia energética y un volumen de trabajo sostenido sin sobrecalentamiento.

En resumen, cumplir con estos requisitos de hardware permitirá que el servidor de IA local multiusuario opere con una eficiencia notable, respaldando las necesidades tanto de Ollama como de Open WebUI. Elegir el hardware adecuado no solo optimiza el rendimiento, sino que también prolonga la vida útil del servidor, asegurando una experiencia fluida y continuada para todos los usuarios.

Sistema Operativo y Software Necesario

Para configurar un servidor de IA local multiusuario utilizando Ollama y Open WebUI, es crucial seleccionar y preparar un sistema operativo adecuado. Las opciones más comunes y ampliamente compatibles incluyen Windows y Ubuntu. Cada uno de estos sistemas operativos ofrece distintas ventajas, y la elección dependerá de tus necesidades específicas y del ambiente de trabajo preferido.

En el caso de usar Windows, primero asegúrate de tener la versión más reciente del sistema operativo, preferiblemente Windows 10 o superior. Luego, instala las actualizaciones necesarias para garantizar la compatibilidad y el rendimiento del software que se va a implementar. Por otro lado, si optas por Ubuntu, la versión recomendada es Ubuntu 20.04 LTS o posterior. Este sistema operativo basado en Linux ofrece una estabilidad notable y es ideal para configuraciones de servidores.

Una vez seleccionado el sistema operativo, el siguiente paso es instalar el servidor principal para correr los modelos de lenguaje, Ollama. La instalación de Ollama puede variar ligeramente según el sistema operativo, pero generalmente, implica descargar el paquete de instalación desde la página oficial de Ollama y seguir las instrucciones proporcionadas. Asegúrate de consultar la documentación oficial para obtener los pasos detallados y cualquier requerimiento adicional.

Para hacer más accesible la administración del servidor y permitir a los usuarios interactuar con los modelos de lenguaje, utilizaremos Docker para implementar Open WebUI, una interfaz web amigable. Docker facilita la gestión de aplicaciones distribuidas, permitiendo desplegar y mantener actualizada la interfaz sin complicaciones significativas. La documentación oficial de Docker es un recurso excelente para guiarte a través del proceso de instalación y configuración.

Después de instalar Docker en tu sistema operativo, procede a descargar y desplegar Open WebUI. Puedes encontrar el contenedor adecuado en el repositorio oficial de Docker Hub o seguir las instrucciones desde la página oficial de Open WebUI. Con estos componentes configurados correctamente, tu servidor de IA local estará listo para su uso multiusuario, facilitando la colaboración y gestión de modelos de lenguaje.

Instalación y Configuración de Ollama

Para comenzar con la instalación de Ollama en su servidor local, lo primero que deberá hacer es descargar el paquete de instalación desde el sitio oficial. Asegúrese de contar con los permisos administrativos necesarios en su sistema operativo para evitar inconvenientes durante la instalación.

Una vez descargado el paquete, descomprímalo en una ubicación adecuada utilizando el comando tar -xvzf ollama-version.tar.gz. Navegue al directorio descomprimido y ejecute el script de instalación con sudo ./install.sh. Este proceso configurará todas las dependencias necesarias y preparará el entorno para Ollama.

Después de completar la instalación, será necesario activar el servicio de Ollama. Esto se realiza usualmente mediante un comando de inicio del servicio especificado en la documentación del software. Por ejemplo, puede iniciar el servicio con sudo systemctl start ollama. Para asegurarse de que el servicio se inicie automáticamente al arrancar el servidor, ejecute sudo systemctl enable ollama.

Es fundamental verificar que Ollama se esté ejecutando correctamente. El servidor debe estar activo y escuchando en el puerto 11434. Para confirmar esto, utilice el comando netstat -tuln | grep 11434. Si la salida muestra que el puerto está en uso por Ollama, significará que el servicio está funcionando correctamente.

Existen algunos problemas comunes que podrían surgir durante la instalación y configuración de Ollama. Uno de ellos es la falta de permisos, que puede solucionarse revisando las configuraciones de usuario y permisos del sistema operativo. Otro problema podría ser relacionado con dependencias faltantes; asegúrese de seguir las recomendaciones de la documentación oficial para resolver estos inconvenientes. En caso de dificultades adicionales, considere consultar los foros de soporte de Ollama o contactar al servicio técnico.

Implementación de Open WebUI mediante Docker

La instalación de Open WebUI mediante Docker permite una implementación más eficiente y portátil de este sistema. A continuación, detallaremos los pasos específicos para configurar Open WebUI utilizando Docker, junto con algunos comandos esenciales para gestionar los contenedores Docker.

Primero, asegúrate de tener Docker instalado en tu servidor. Puedes verificar la instalación ejecutando el comando docker --version. Si Docker no está instalado, sigue las instrucciones oficiales en la documentación del sitio web de Docker.

Una vez que Docker esté instalado, puedes proceder a descargar la imagen de Open WebUI. Ejecuta el siguiente comando para obtener la imagen desde Docker Hub:

docker pull openwebui/image:latestCon la imagen de Open WebUI descargada, el siguiente paso es crear y ejecutar un contenedor Docker. Utiliza el siguiente comando para inicializar el contenedor:

docker run -d -p 8080:80 --name openwebui_container openwebui/image:latestEste comando indica a Docker que ejecute el contenedor en segundo plano (-d), mapee el puerto 80 del contenedor al puerto 8080 de la máquina anfitriona (-p 8080:80), y nombre el contenedor como openwebui_container. Puedes ajustar estos parámetros según sea necesario para tu configuración específica.

Configuración de la Interfaz Gráfica

Después de iniciar el contenedor, Open WebUI debería estar accesible a través de tu navegador web en la URL http://localhost:8080 (o el puerto especificado). La interfaz gráfica permite gestionar diferentes aspectos del funcionamiento del servidor de manera intuitiva.

Gestión de Usuarios

Para añadir usuarios al sistema, es recomendable acceder a las herramientas de gestión de Open WebUI a través del navegador. Normalmente, dentro de la interfaz gráfica, encontrarás secciones dedicadas a la administración de usuarios y permisos, donde puedes crear nuevos perfiles y asignar privilegios adecuados.

Por último, la gestión de contenedores Docker puede incluir comandos adicionales, como detener un contenedor (docker stop openwebui_container), reiniciarlo (docker restart openwebui_container), o eliminarlo cuando ya no sea necesario (docker rm openwebui_container). Esto te permitirá mantener un control riguroso sobre los recursos y servicios que están operativos en tu servidor.

Configuraciones Multiusuario y Accesibilidad

La implementación de configuraciones multiusuario es fundamental cuando se desarrolla un servidor de IA local, especialmente cuando se desea democratizar el acceso a múltiples dispositivos. A pesar de la eficacia de Ollama en manejar tareas de inteligencia artificial, este no contempla de manera predeterminada la gestión multiusuario. Aquí es donde entra en juego Open WebUI, una herramienta robusta diseñada para orquestar la interacción de varios usuarios simultáneamente.

Para establecer un entorno multiusuario funcional, es indispensable que todos los dispositivos involucrados, ya sean PCs antiguos, dispositivos móviles o incluso Raspberry Pi, estén conectados a la misma red local. La interoperabilidad en una red local asegura que todos los usuarios puedan acceder al servidor de IA sin experimentar latencias significativas. Es recomendable utilizar una red Wi-Fi de alta capacidad o conexiones Ethernet para minimizar los posibles cuellos de botella en la transferencia de datos.

El primer paso en la configuración es asegurar que Open WebUI esté correctamente instalado en el servidor. Esta interfaz gráfica habilita la creación y administración de cuentas de usuario, asignando permisos y prioridades según las necesidades del entorno. Además, Open WebUI permite la monitorización en tiempo real del uso de recursos, asegurando que el rendimiento del servidor de IA se mantenga óptimo incluso bajo carga múltiple.

Una vez configurado Open WebUI, es necesario proceder a la integración de los distintos dispositivos. El proceso generalmente incluye la adquisición de direcciones IP dentro de la misma subred y la configuración de clientes Open WebUI en cada dispositivo. Este paso garantiza que cada usuario pueda interactuar con el servidor de IA como si estuviera directamente conectado a él.

Requisitos adicionales incluyen la habilitación de puertos específicos en el router para facilitar la comunicación entre el servidor y los dispositivos cliente, así como la implementación de medidas de seguridad como el cifrado SSL para proteger los datos transferidos a través de la red.

Con estas configuraciones, se logra un entorno multiusuario eficaz y accesible, potenciando la colaboración y la eficiencia en el uso de recursos de inteligencia artificial en una red local.

Configuraciones Avanzadas

En la implementación de un servidor de inteligencia artificial local multiusuario, las configuraciones avanzadas juegan un papel crucial para garantizar un acceso optimizado y seguro desde distintos dispositivos, incluyendo dispositivos externos y móviles. Un aspecto clave de esta configuración es modificar el archivo de configuración de Ollama para que escuche en todas las interfaces de red. Para lograr esto, abra el archivo de configuración de Ollama y establezca la dirección IP a “0.0.0.0”. Esta modificación permitirá que el servidor acepte conexiones desde cualquier dirección IP, facilitando el acceso desde dispositivos fuera de la red local.

Otro aspecto importante es la configuración de seguridad. Es esencial garantizar que solo usuarios autorizados puedan acceder al servidor de IA. Una manera de conseguir esto es implementando el control de acceso basado en roles (RBAC), que permite asignar diferentes niveles de permisos a distintos usuarios. También es aconsejable utilizar certificados SSL para cifrar las comunicaciones entre el servidor y los clientes, protegiendo los datos sensibles contra posibles amenazas.

Para escenarios personalizados, como el trabajo remoto o el uso en dispositivos de menor capacidad, se pueden realizar ajustes específicos. Por ejemplo, para optimizar el rendimiento en dispositivos móviles, considere reducir la carga computacional del servidor distribuyendo algunas tareas a los dispositivos cliente, una técnica conocida como “edge computing”. Esta aproximación puede mejorar significativamente la latencia y el tiempo de respuesta, particularmente en redes de alta latencia o bajo ancho de banda.

Además, si se espera un uso intensivo del servidor desde ubicaciones remotas, es recomendable implementar técnicas de balanceo de carga y replicación de datos. Los balances de carga pueden distribuir efectivamente las solicitudes entre múltiples instancias del servidor, evitando cuellos de botella y mejorando la disponibilidad y escalabilidad del sistema. La replicación de datos, por otro lado, garantiza que los datos estén disponibles en múltiples ubicaciones, ofreciendo redundancia y mayor resiliencia ante fallos.

Recomendaciones Finales

Para optimizar al máximo el uso de un servidor de IA local multiusuario con Ollama y Open WebUI, es esencial seguir algunas recomendaciones clave. En primer lugar, centralizar tanto los modelos de IA como la interfaz web en un único servidor facilita el acceso común desde múltiples dispositivos. Esta centralización no sólo simplifica la administración y el despliegue, sino que también mejora la eficiencia y reduce los potenciales problemas de incompatibilidad entre dispositivos y versiones.

Además, es altamente aconsejable utilizar modelos de lenguaje más ligeros en dispositivos móviles. Estos modelos optimizados no sólo mejoran significativamente el rendimiento y la velocidad de respuesta, sino que también conservan los recursos del dispositivo, extendiendo así la vida útil de la batería y la usabilidad en escenarios móviles. Los usuarios deben evaluar cuál modelo se adapta mejor a sus necesidades específicas, considerando tanto la precisión del modelo como la eficiencia en términos de recursos.

Otro aspecto crucial a considerar son las licencias de uso de los modelos de IA escogidos. Es imperativo revisar y cumplir con las licencias, especialmente si se planea un uso comercial. Las licencias pueden variar considerablemente; algunas permiten un uso libre no comercial, mientras que otras pueden exigir tarifas o restricciones adicionales cuando se utiliza en un entorno comercial. Ignorar estas licencias puede resultar en efectos legales adversos y limitar el uso potencial de los modelos.

Finalmente, es prudente mantenerse actualizado sobre las últimas versiones y actualizaciones tanto del software Ollama como del Open WebUI. La comunidad de desarrolladores suele mejorar la seguridad, la funcionalidad y la eficiencia de estos productos mediante lanzamientos regulares. Implementar las últimas actualizaciones asegura que el servidor de IA multiusuario funcione de manera segura y eficiente, maximizando así el retorno de la inversión y la satisfacción del usuario.

Adoptar estas recomendaciones ayudará a establecer una configuración robusta y eficiente de su servidor de IA local, optimizando la experiencia y facilitando el acceso desde diferentes dispositivos mientras se asegura el cumplimiento de las licencias de uso.

Sección de Cursos Online y Enlaces a Videos de YouTube:

Para quienes deseen profundizar en la configuración y el uso de servidores de inteligencia artificial locales, a continuación, se presentan algunos recursos recomendados:

- Curso Online sobre Configuración de Servidores de IA: Este curso ofrece una visión completa desde la instalación de Ollama hasta la personalización avanzada de Open WebUI.

- Videos de YouTube Recomendados:

- Guía de Instalación de Docker y Open WebUI: Un video paso a paso que muestra cómo configurar Docker y Open WebUI en un entorno local.

- Optimización de Hardware para Servidores de IA: Consejos y trucos para elegir y optimizar el hardware necesario para un servidor de IA eficiente.

Conclusión

Implementar un servidor de inteligencia artificial local utilizando Ollama y Open WebUI puede parecer una tarea desafiante, pero con los recursos adecuados, es totalmente alcanzable incluso para quienes no tienen un profundo conocimiento técnico. Este enfoque permite a pequeñas empresas, desarrolladores independientes, y entusiastas de la IA ejecutar grandes modelos de lenguaje de manera segura, sin depender de conexiones externas a Internet, lo que mejora la privacidad y el control sobre los datos. Además, la flexibilidad para conectar múltiples dispositivos y la capacidad de personalizar la configuración según las necesidades específicas del proyecto hacen que esta solución sea altamente versátil. Si sigues los pasos detallados en esta guía, estarás en camino de tener un sistema robusto y eficiente para tus aplicaciones de IA.